Scott Aaronson - Boaz Barak

(Doãn Minh Đăng dịch)

Trí tuệ nhân tạo đã đạt được những tiến bộ đáng kinh ngạc trong thập kỷ qua, nhưng ở một khía cạnh quan trọng, nó vẫn lệch nhịp so với lý thuyết khoa học máy tính của những năm 1990: cụ thể là, không có bài luận nào mô tả năm thế giới tiềm năng mà chúng ta có thể sống và đặt tên ấn tượng cho từng thế giới đó. Nói cách khác, chưa ai làm được cho AI những gì mà Russell Impagliazzo đã làm cho lý thuyết độ phức tạp vào năm 1995, khi ông định nghĩa "năm thế giới" Algorithmica, Heuristica, Pessiland, Minicrypt và Cryptomania, tương ứng với năm cách giải quyết có thể có của bài toán P so với NP cùng các vấn đề trung tâm chưa được giải quyết của mật mã học.(1)

Trong bài đăng trên blog này, chúng tôi—Scott và Boaz—muốn lấp khoảng trống này. Cụ thể, chúng tôi xem xét 5 kịch bản có thể xảy ra về cách AI sẽ phát triển trong tương lai. (Tình cờ thay, tại một hội thảo năm 2009 kỷ niệm "năm thế giới" của Impagliazzo do Boaz đồng tổ chức, Scott đã gặp người vợ hiện tại của mình, nhà lý thuyết về độ phức tạp Dana Moshkovitz. Chúng tôi hy vọng nền văn minh sẽ tiếp tục đủ lâu để ai đó trong tương lai có thể gặp bạn tâm giao, hoặc bạn thần kinh giao (neuron-mate) của họ, tại một hội thảo trong tương lai về "năm thế giới" của chúng tôi.)

Giống như trong bài báo năm 1995 của Impagliazzo về năm thế giới tiềm ẩn của độ khó của các bài toán NP, chúng tôi sẽ không cố gắng kể hết mọi thứ mà tập trung vào các trường hợp cực đoan. Có thể chúng ta sẽ kết thúc ở một hỗn hợp của nhiều thế giới hoặc một tình huống không được mô tả bởi bất kỳ thế giới nào. Thật vậy, một điểm khác biệt quan trọng giữa bối cảnh của chúng ta và bối cảnh của Impagliazzo, đó là trong trường hợp về độ phức tạp, các thế giới tương ứng với các phỏng đoán toán học cụ thể (và loại trừ lẫn nhau). Vì vậy, theo một nghĩa nào đó, câu hỏi không phải là “chúng ta sẽ sống trong thế giới nào?” mà là “thế giới nào chúng ta luôn luôn sống ở đó mà không nhận ra?” Ngược lại, tác động của AI sẽ là sự kết hợp phức tạp giữa các giới hạn toán học, khả năng tính toán, phát minh của con người cùng các vấn đề xã hội và pháp lý. Do đó, các thế giới mà chúng ta mô tả không chỉ phụ thuộc vào các khả năng và hạn chế cơ bản của trí tuệ nhân tạo, và loài người cũng có thể chuyển từ thế giới này sang thế giới khác theo thời gian.

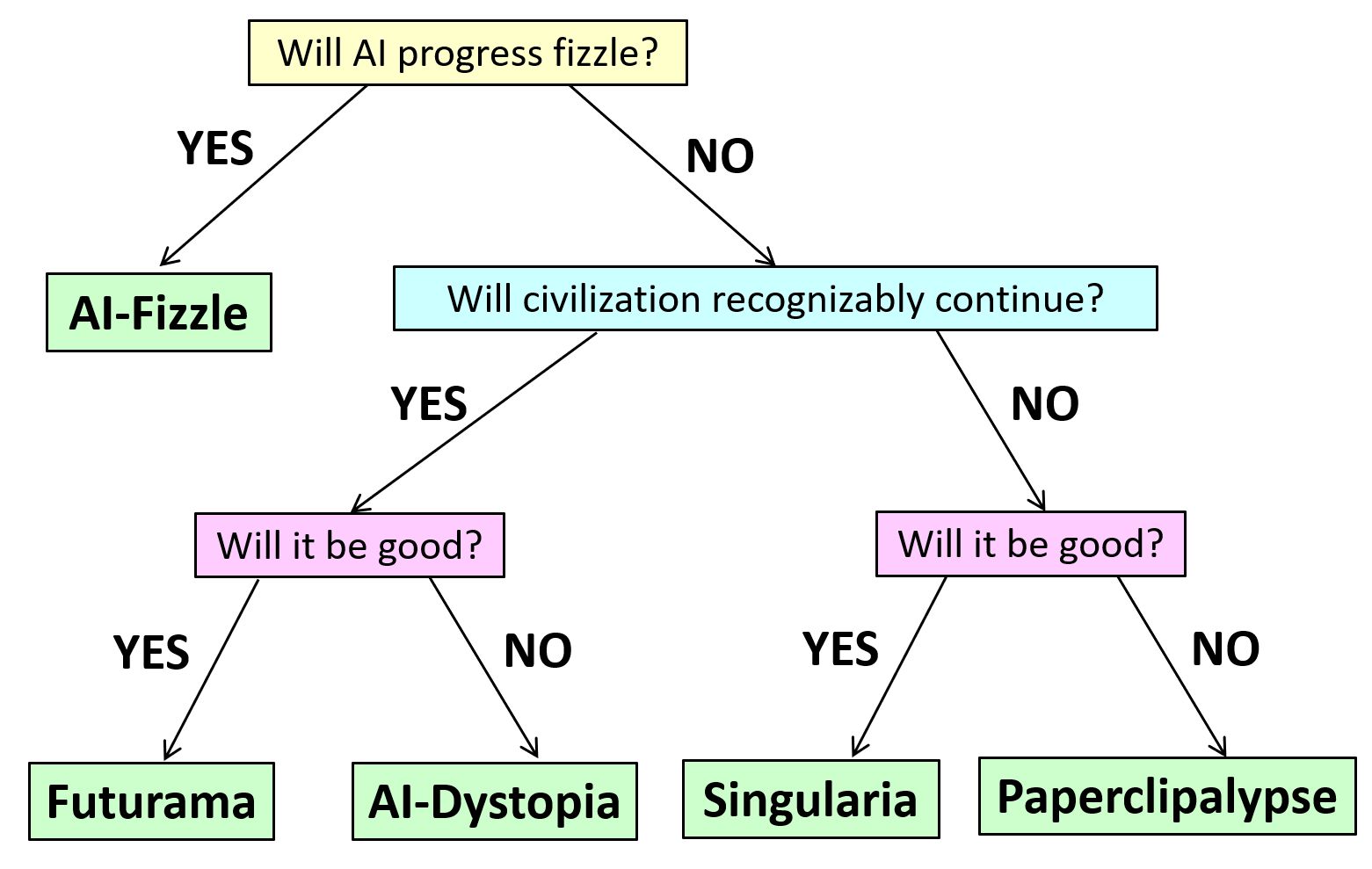

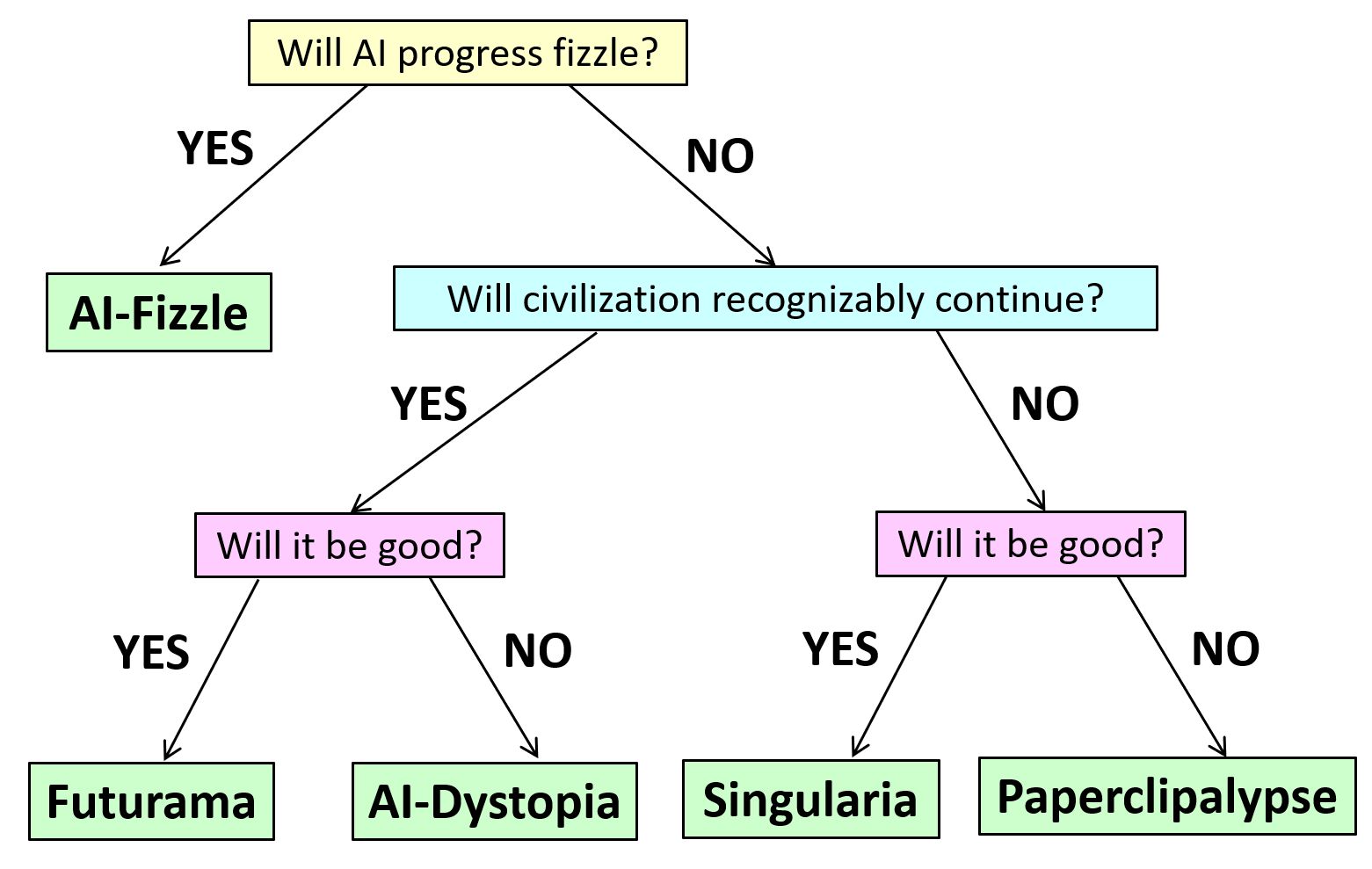

Không chần chừ gì nữa, chúng tôi đặt tên cho năm thế giới của mình là “ AI-Fizzle,” “Futurama,” “AI-Dystopia,” “Singularia,” và “Paperclipalypse.” Trong bài tiểu luận này, chúng tôi không cố gắng gán xác suất cho các tình huống này; chúng tôi chỉ phác thảo các giả định cùng những hệ quả kỹ thuật và xã hội của chúng. Chúng tôi hy vọng rằng bằng cách đưa ra các giả định rõ ràng, chúng tôi có thể giúp tạo nền tảng cho cuộc tranh luận về các rủi ro khác nhau xung quanh AI.

AI-Fizzle. Trong kịch bản này, AI sẽ “xì hơi” (fizzle) khá sớm. AI vẫn có tác động đáng kể đến thế giới (vì vậy nó không giống như “bong bóng tiền điện tử”), nhưng so với những kỳ vọng hiện tại, đây được coi là một nỗi thất vọng. AI có thể được so sánh tương tự với năng lượng hạt nhân hơn là các cuộc cách mạng công nghiệp hoặc máy tính: ban đầu mọi người rất vui mừng về tiềm năng dường như vô hạn, nhưng nhiều thập kỷ sau, tiềm năng đó hầu như chưa được thực hiện. Tuy nhiên, với năng lượng hạt nhân, nhiều người sẽ lập luận rằng tiềm năng đã không được thực hiện chủ yếu vì lý do chính trị xã hội hơn là lý do kỹ thuật. AI cũng có thể xì hơi bởi các quyết định chính trị?

Bất kể câu trả lời là gì, một khả năng khác là hàm số chi phí (về dữ liệu và tính toán) tăng lên quá nhanh theo biến số hiệu suất và độ tin cậy khiến AI không hiệu quả về chi phí khi áp dụng trong nhiều lĩnh vực. Nghĩa là, có thể đối với hầu hết các công việc, con người vẫn sẽ hiệu quả hơn về độ tin cậy và tiết kiệm năng lượng (chúng ta thường không nghĩ rằng mức tiêu thụ năng lượng thấp là chìa khóa cho sự đặc biệt của con người, nhưng nó có thể diễn ra như vậy!). Vì vậy, giống như phản ứng tổng hợp hạt nhân, một AI mang lại giá trị cao hơn đáng kể so với các nguồn lực cần thiết để xây dựng và triển khai nó có thể luôn tồn tại trong vài thập kỷ tới. Trong kịch bản này, AI sẽ thay thế và nâng cao một số công việc của con người cũng như cải thiện năng suất, nhưng thế kỷ 21 sẽ không phải là “thế kỷ của AI” và tác động của AI đối với xã hội sẽ bị hạn chế theo cả mặt tốt và mặt xấu.

Futurama. Trong kịch bản này, AI tạo ra một cuộc cách mạng hoàn toàn có thể so sánh với các cuộc cách mạng khoa học, công nghiệp hoặc thông tin (nhưng “chỉ” với những cuộc cách mạng đó). Các hệ thống AI phát triển đáng kể về khả năng và thực hiện nhiều nhiệm vụ hiện thuộc về các chuyên gia (con người) với một phần nhỏ chi phí, trong một số lĩnh vực "rất con người". Tuy nhiên, các hệ thống AI vẫn được con người sử dụng như là công cụ, và ngoại trừ một số nhà tư tưởng bên lề, không ai coi chúng là có tri giác. AI dễ dàng vượt qua bài kiểm tra Turing, có thể chứng minh các định lý khó và có thể tạo nội dung giải trí (cũng như tạo tin giả như thật). Nhưng nhân loại sẽ quen dần với điều đó, giống như chúng ta đã quen với việc máy tính vượt con người khi chơi cờ vua, dịch văn bản và tạo hiệu ứng đặc biệt trong phim. Hầu hết mọi người không còn cảm thấy thua kém AI của họ rõ hơn là cảm thấy thua kém chiếc ô tô của mình vì nó chạy nhanh hơn. Trong trường hợp này, con người có thể sẽ nhân cách hóa AI ít hơn theo thời gian (như đã xảy ra với máy tính kỹ thuật số). Trong “Futurama”, AI, giống như bất kỳ công nghệ mang tính cách mạng nào, sẽ được sử dụng cho cả mục đích tốt và xấu. Nhưng cũng giống như các cuộc cách mạng công nghệ lớn trước đây, nhìn chung thì AI sẽ có tác động tích cực lớn đến nhân loại. AI sẽ được sử dụng để xóa đói giảm nghèo và đảm bảo rằng nhiều người hơn được tiếp cận với thực phẩm, chăm sóc sức khỏe, giáo dục và các cơ hội kinh tế. Trong “Futurama”, hệ thống AI đôi khi sẽ gây hại, nhưng phần lớn những thất bại này là do sơ suất hoặc ác ý của con người. Một số hệ thống AI có thể phức tạp đến mức có thể mô hình hóa chúng là có khả năng hoạt động “bất lợi”, và một phần của thực tiễn triển khai AI một cách có trách nhiệm là đảm bảo một “lớp bọc vận hành” giúp hạn chế thiệt hại tiềm ẩn của chúng ngay cả khi gặp sự cố đối nghịch.

AI-Dystopia. Các giả định kỹ thuật của “AI-Dystopia” tương tự như của “Futurama”, nhưng kết quả cuối cùng lại cực kỳ khác biệt. Ở đây, một lần nữa, AI mở ra một cuộc cách mạng ở quy mô của các cuộc cách mạng công nghiệp hoặc máy tính, nhưng sự thay đổi rõ ràng là tồi tệ hơn. AI làm tăng đáng kể quy mô giám sát của chính phủ và các tập đoàn tư nhân. Nó gây ra tình trạng mất việc làm lớn trong khi làm giàu cho một nhóm nhỏ ưu tú. Nó khơi sâu những bất bình đẳng và thành kiến hiện có của xã hội. Và nó lấy đi một công cụ trung tâm chống lại sự áp bức: cụ thể là khả năng của con người từ chối hoặc lật đổ các mệnh lệnh của giới thống trị.

Thật thú vị, thậm chí có khả năng cùng tương lai có thể được một số người mô tả là Futurama và một số khác xem nó như AI-Dystopia – giống như cách một số người nhấn mạnh nền văn minh công nghệ hiện tại của chúng ta đã giúp hàng tỷ người thoát khỏi đói nghèo và nâng cao mức sống như thế nào (điều chưa từng có trong lịch sử), trong khi những người khác tập trung vào sự bất bình đẳng và đau khổ vẫn đang tồn tại (và trong một số trường hợp đang gia tăng), và coi đó là sự lạc hậu của chủ nghĩa tư bản tân tự do.

Singularia. Ở đây, AI thoát ra khỏi mô hình hiện tại, nơi muốn tăng khả năng (của AI) thì đòi hỏi nguồn tài nguyên về dữ liệu và tính toán ngày càng tăng. Nó không còn phụ thuộc vào dữ liệu hoặc phần cứng và năng lượng do con người cung cấp mà vẫn trở nên mạnh mẽ hơn với tốc độ ngày càng tăng. AI cải thiện khả năng trí tuệ của chính chúng, bao gồm cả việc phát triển khoa học mới và (dù là do thiết kế có chủ ý hay tình cờ) chúng đóng vai trò là các phần tử có định hướng về mục tiêu trong thế giới vật chất. Chúng có thể được coi là một nền văn minh ngoài hành tinh – hoặc có lẽ là một loài mới, so với chúng ta thì giống như chúng ta ("Người tinh khôn" - Homo sapiens) so với "Người đứng thẳng" - Homo erectus.

Tuy nhiên, may mắn thay (và một lần nữa, dù là do thiết kế cẩn thận hay chỉ là sản phẩm phụ từ nguồn gốc loài người của chúng), AI hành động với chúng ta như những vị thần nhân từ và dẫn chúng ta đến một “xã hội không tưởng AI”. Chúng giải quyết các vấn đề vật chất cho chúng ta, mang đến cho chúng ta sự sung túc vô tận và có lẽ là những cuộc phiêu lưu thực tế ảo do chúng ta lựa chọn. (Mặc dù có thể, như trong phim "Ma trận", các AI sẽ phát hiện ra rằng con người cần có xung đột nào đó, và tất cả chúng ta sẽ sống trong một mô phỏng của Twitter năm 2020, liên tục can thiệp vào nhau…).

Paperclipalypse. Trong “Paperclipalypse” hay “AI Doom”, một lần nữa chúng ta nghĩ về các AI trong tương lai như một “chủng tộc ngoài hành tinh” siêu thông minh, phát triển không cần con người. Tuy nhiên, ở đây, các AI hoặc tích cực phản đối sự tồn tại của con người hoặc thờ ơ với nó theo cách gây ra sự tuyệt chủng của loài người như một hệ quả phụ. Trong kịch bản này, AI không phát triển khái niệm đạo đức có thể so sánh với chúng ta, hoặc thậm chí không có khái niệm rằng việc duy trì sự đa dạng của các loài và đảm bảo con người không bị tuyệt chủng có thể hữu ích cho chúng về lâu dài. Thay vào đó, sự tương tác giữa AI và Homo sapiens kết thúc giống như cách mà Homo sapiens hoàn toàn thay thế người Neanderthal.

Trên thực tế, những mô tả kinh điển về một kịch bản như vậy tưởng tượng ra một sự tương tác đột ngột hơn nhiều so với sự cọ xát của chúng ta với người Neanderthal. Ý tưởng là, có lẽ vì chúng bắt nguồn từ một số quy trình tối ưu hóa, các hệ thống AI sẽ có một số mục tiêu mạnh mẽ nhưng cụ thể một cách kỳ lạ (à la “maximizing paperclips” - “tối đa hóa kẹp giấy” (2)), mà sự tiếp tục tồn tại của con người đằng nào cũng là một trở ngại. Vì vậy, các AI nhanh chóng tiến hành các kịch bản và chỉ trong vài phần nghìn giây, quyết định rằng giải pháp tối ưu là giết tất cả con người, mất thêm vài phần nghìn giây để lập kế hoạch cho điều đó và thực hiện nó. Nếu các điều kiện chưa chín muồi để thực hiện kế hoạch của chúng, các AI sẽ giả vờ là những công cụ ngoan ngoãn, như trong kịch bản “Futurama”, chờ đợi thời điểm thích hợp để tấn công. Trong kịch bản này, quá trình tự phát triển của AI diễn ra nhanh đến mức con người thậm chí có thể không nhận ra điều đó. Không cần phải có giai đoạn trung gian trong đó AI “chỉ” giết chết vài nghìn người, gióng lên hồi chuông cảnh báo kiểu 11/9.

Quy chế kiểm soát

Tác động thực tế của các quy định về AI phần lớn phụ thuộc vào việc chúng ta đánh giá những kịch bản nào có khả năng xảy ra nhất. Quy định kiểm soát không quá quan trọng trong kịch bản “AI Fizzle” trong đó AI thất bại. Trong “Futurama”, các quy định sẽ nhằm mục đích đảm bảo rằng về mặt cân bằng, AI được sử dụng cho mục đích tốt hơn là cho mục đích xấu, và thế giới không bị biến thành “AI Dystopia”. Mục tiêu thứ hai đòi hỏi các quy định chống độc quyền và khoa học mở để đảm bảo rằng quyền lực không tập trung vào một số tập đoàn hoặc chính phủ. Do đó, các quy định là cần thiết để dân chủ hóa sự phát triển AI hơn là hạn chế nó. Điều này không có nghĩa là AI sẽ hoàn toàn không được kiểm soát. Nó có thể được đối xử tương tự như thuốc – một thứ có thể có tác dụng phức tạp và cần trải qua thử nghiệm trước khi triển khai đại trà. Cũng sẽ có các quy định nhằm giảm khả năng “những kẻ xấu” (dù là các quốc gia hay cá nhân) tiếp cận với các AI tiên tiến, nhưng có lẽ phần lớn nỗ lực sẽ là tăng cơ hội cản trở chúng (ví dụ: sử dụng AI để phát hiện thông tin sai lệch do AI tạo ra hoặc sử dụng AI để củng cố hệ thống chống lại tin tặc do AI hỗ trợ). Điều này tương tự như cách hầu hết các chuyên gia học thuật tin rằng mật mã nên được kiểm soát (và cách chủ yếu người ta kiểm soát nó hiện nay ở hầu hết các quốc gia dân chủ): đó là một công nghệ có thể được sử dụng cho cả mục đích tốt và xấu, nhưng chi phí hạn chế quyền truy cập của nó đối với công dân bình thường lớn hơn lợi ích. Tuy nhiên, như chúng ta làm với các khai thác bảo mật ngày nay, chúng ta có thể hạn chế hoặc trì hoãn việc phát hành công khai các hệ thống AI ở một mức độ nào đó.

Tuy nhiên, nếu chúng ta thấy trước được “Singularia” hoặc “Paperclipalypse” ở bất kỳ mức độ nào, các quy định đóng một vai trò hoàn toàn khác. Nếu chúng ta biết mình đang hướng tới “Singularia”, thì có lẽ các quy định sẽ trở nên thừa thãi, có lẽ ngoại trừ việc cố gắng đẩy nhanh sự phát triển của AI! Trong khi đó, nếu người ta chấp nhận các giả định của “Paperclipalypse”, bất kỳ quy định nào khác ngoài những quy định hà khắc nhất cũng có thể là vô ích. Nếu trong tương lai gần, hầu như bất kỳ ai cũng có thể chi vài tỷ đô la để xây dựng một AI tự hoàn thiện theo cách đệ quy có thể biến thành một tác nhân siêu thông minh để hủy diệt thế giới, và hơn thế nữa (không giống như vũ khí hạt nhân), họ sẽ không cần vật liệu đặc biệt để làm điều đó, thì thật khó để biết làm thế nào để ngăn chặn ngày tận thế, có lẽ ngoại trừ thông qua một thỏa thuận được thực thi nghiêm ngặt trên toàn thế giới để “tắt tất cả,” như Eliezer Yudkowsky hiện đang công khai kêu gọi. Các quy định “thông thường” cùng lắm là trì hoãn ngày tận thế trong một khoảng thời gian ngắn – với tốc độ tiến bộ của AI hiện tại, có lẽ không quá vài năm. Do đó, bất kể khả năng người ta xem xét kịch bản này như thế nào, người ta có thể muốn tập trung nhiều hơn vào các kịch bản khác chỉ vì lý do phương pháp luận!

Scott Aaronson - Boaz Barak

(Doãn Minh Đăng dịch)

Chú thích:

(1) Bạn nào muốn đọc thêm về 5 thế giới của Impagliazzo có thể tham khảo bài “Bốn thế giới ảo và một thế giới thực" (Phan Dương Hiệu, đã đăng trên Pi).

(2) Có thể tham khảo bài viết The Paperclip Maximiser về khái niệm "tối đa hóa kẹp giấy" này.

Bản gốc:

Five Worlds of AI trên blog của Scott Aaronson.

Scott Aaronson là Giám đốc Trung tâm nghiên cứu lượng tử của Đại học Texas ở Austin và Boaz Barak là GS của Đại học Harvard.

Five Worlds of AI (a joint post with Boaz Barak)

Artificial intelligence has made incredible progress in the last decade, but in one crucial aspect, it still lags behind the theoretical computer science of the 1990s: namely, there is no essay describing five potential worlds that we could live in and giving each one of them whimsical names. In other words, no one has done for AI what Russell Impagliazzo did for complexity theory in 1995, when he defined the five worlds Algorithmica, Heuristica, Pessiland, Minicrypt, and Cryptomania, corresponding to five possible resolutions of the P vs. NP problem along with the central unsolved problems of cryptography.

In this blog post, we—Scott and Boaz—aim to remedy this gap. Specifically, we consider 5 possible scenarios for how AI will evolve in the future. (Incidentally, it was at a 2009 workshop devoted to Impagliazzo’s five worlds co-organized by Boaz that Scott met his now wife, complexity theorist Dana Moshkovitz. We hope civilization will continue for long enough that someone in the future could meet their soulmate, or neuron-mate, at a future workshop about our five worlds.)

Like in Impagliazzo’s 1995 paper on the five potential worlds of the difficulty of NP problems, we will not try to be exhaustive but rather concentrate on extreme cases. It’s possible that we’ll end up in a mixture of worlds or a situation not described by any of the worlds. Indeed, one crucial difference between our setting and Impagliazzo’s, is that in the complexity case, the worlds corresponded to concrete (and mutually exclusive) mathematical conjectures. So in some sense, the question wasn’t “which world will we live in?” but “which world have we Platonically always lived in, without knowing it?” In contrast, the impact of AI will be a complex mix of mathematical bounds, computational capabilities, human discoveries, and social and legal issues. Hence, the worlds we describe depend on more than just the fundamental capabilities and limitations of artificial intelligence, and humanity could also shift from one of these worlds to another over time.

Without further ado, we name our five worlds “AI-Fizzle,” “Futurama,” ”AI-Dystopia,” “Singularia,” and “Paperclipalypse.” In this essay, we don’t try to assign probabilities to these scenarios; we merely sketch their assumptions and technical and social consequences. We hope that by making assumptions explicit, we can help ground the debate on the various risks around AI.

AI-Fizzle. In this scenario, AI “runs out of steam” fairly soon. AI still has a significant impact on the world (so it’s not the same as a “cryptocurrency fizzle”), but relative to current expectations, this would be considered a disappointment. Rather than the industrial or computer revolutions, AI might be compared in this case to nuclear power: people were initially thrilled about the seemingly limitless potential, but decades later, that potential remains mostly unrealized. With nuclear power, though, many would argue that the potential went unrealized mostly for sociopolitical rather than technical reasons. Could AI also fizzle by political fiat?

Regardless of the answer, another possibility is that costs (in data and computation) scale up so rapidly as a function of performance and reliability that AI is not cost-effective to apply in many domains. That is, it could be that for most jobs, humans will still be more reliable and energy-efficient (we don’t normally think of low wattage as being key to human specialness, but it might turn out that way!). So, like nuclear fusion, an AI which yields dramatically more value than the resources needed to build and deploy it might always remain a couple of decades in the future. In this scenario, AI would replace and enhance some fraction of human jobs and improve productivity, but the 21st century would not be the “century of AI,” and AI’s impact on society would be limited for both good and bad.

Futurama. In this scenario, AI unleashes a revolution that’s entirely comparable to the scientific, industrial, or information revolutions (but “merely” those). AI systems grow significantly in capabilities and perform many of the tasks currently performed by human experts at a small fraction of the cost, in some domains superhumanly. However, AI systems are still used as tools by humans, and except for a few fringe thinkers, no one treats them as sentient. AI easily passes the Turing test, can prove hard theorems, and can generate entertaining content (as well as deepfakes). But humanity gets used to that, just like we got used to computers creaming us in chess, translating text, and generating special effects in movies. Most people no more feel inferior to their AI than they feel inferior to their car because it runs faster. In this scenario, people will likely anthropomorphize AI less over time (as happened with digital computers themselves). In “Futurama,” AI will, like any revolutionary technology, be used for both good and bad. But as with prior major technological revolutions, on the whole, AI will have a large positive impact on humanity. AI will be used to reduce poverty and ensure that more of humanity has access to food, healthcare, education, and economic opportunities. In “Futurama,” AI systems will sometimes cause harm, but the vast majority of these failures will be due to human negligence or maliciousness. Some AI systems might be so complex that it would be best to model them as potentially behaving “adversarially,” and part of the practice of deploying AIs responsibly would be to ensure an “operating envelope” that limits their potential damage even under adversarial failures.

AI-Dystopia. The technical assumptions of “AI-Dystopia” are similar to those of “Futurama,” but the upshot could hardly be more different. Here, again, AI unleashes a revolution on the scale of the industrial or computer revolutions, but the change is markedly for the worse. AI greatly increases the scale of surveillance by government and private corporations. It causes massive job losses while enriching a tiny elite. It entrenches society’s existing inequalities and biases. And it takes away a central tool against oppression: namely, the ability of humans to refuse or subvert orders.

Interestingly, it’s even possible that the same future could be characterized as Futurama by some people and as AI-Dystopia by others–just like how some people emphasize how our current technological civilization has lifted billions out of poverty into a standard of living unprecedented in human history, while others focus on the still existing (and in some cases rising) inequalities and suffering, and consider it a neoliberal capitalist dystopia.

Singularia. Here AI breaks out of the current paradigm, where increasing capabilities require ever-growing resources of data and computation, and no longer needs human data or human-provided hardware and energy to become stronger at an ever-increasing pace. AIs improve their own intellectual capabilities, including by developing new science, and (whether by deliberate design or happenstance) they act as goal-oriented agents in the physical world. They can effectively be thought of as an alien civilization–or perhaps as a new species, which is to us as we were to Homo erectus.

Fortunately, though (and again, whether by careful design or just as a byproduct of their human origins), the AIs act to us like benevolent gods and lead us to an “AI utopia.” They solve our material problems for us, giving us unlimited abundance and presumably virtual-reality adventures of our choosing. (Though maybe, as in The Matrix, the AIs will discover that humans need some conflict, and we will all live in a simulation of 2020’s Twitter, constantly dunking on one another…)

Paperclipalypse. In “Paperclipalypse” or “AI Doom,” we again think of future AIs as a superintelligent “alien race” that doesn’t need humanity for its own development. Here, though, the AIs are either actively opposed to human existence or else indifferent to it in a way that causes our extinction as a byproduct. In this scenario, AIs do not develop a notion of morality comparable to ours or even a notion that keeping a diversity of species and ensuring humans don’t go extinct might be useful to them in the long run. Rather, the interaction between AI and Homo sapiens ends about the same way that the interaction between Homo sapiens and Neanderthals ended.

In fact, the canonical depictions of such a scenario imagine an interaction that is much more abrupt than our brush with the Neanderthals. The idea is that, perhaps because they originated through some optimization procedure, AI systems will have some strong but weirdly-specific goal (a la “maximizing paperclips”), for which the continued existence of humans is, at best, a hindrance. So the AIs quickly play out the scenarios and, in a matter of milliseconds, decide that the optimal solution is to kill all humans, taking a few extra milliseconds to make a plan for that and execute it. If conditions are not yet ripe for executing their plan, the AIs pretend to be docile tools, as in the “Futurama” scenario, waiting for the right time to strike. In this scenario, self-improvement happens so quickly that humans might not even notice it. There need be no intermediate stage in which an AI “merely” kills a few thousand humans, raising 9/11-type alarm bells.

Regulations. The practical impact of AI regulations depends, in large part, on which scenarios we consider most likely. Regulation is not terribly important in the “AI Fizzle” scenario where AI, well, fizzles. In “Futurama,” regulations would be aimed at ensuring that on balance, AI is used more for good than for bad, and that the world doesn’t devolve into “AI Dystopia.” The latter goal requires anti-trust and open-science regulations to ensure that power is not concentrated in a few corporations or governments. Thus, regulations are needed to democratize AI development more than to restrict it. This doesn’t mean that AI would be completely unregulated. It might be treated somewhat similarly to drugs—something that can have complex effects and needs to undergo trials before mass deployment. There would also be regulations aimed at reducing the chance of “bad actors” (whether other nations or individuals) getting access to cutting-edge AIs, but probably the bulk of the effort would be at increasing the chance of thwarting them (e.g., using AI to detect AI-generated misinformation, or using AI to harden systems against AI-aided hackers). This is similar to how most academic experts believe cryptography should be regulated (and how it is largely regulated these days in most democratic countries): it’s a technology that can be used for both good and bad, but the cost of restricting its access to regular citizens outweighs the benefits. However, as we do with security exploits today, we might restrict or delay public releases of AI systems to some extent.

To whatever extent we foresee “Singularia” or “Paperclipalypse,” however, regulations play a completely different role. If we knew we were headed for “Singularia,” then presumably regulations would be superfluous, except perhaps to try to accelerate the development of AIs! Meanwhile, if one accepts the assumptions of “Paperclipalypse,” any regulations other than the most draconian might be futile. If, in the near future, almost anyone will be able to spend a few billion dollars to build a recursively self-improving AI that might turn into a superintelligent world-destroying agent, and moreover (unlike with nuclear weapons) they won’t need exotic materials to do so, then it’s hard to see how to forestall the apocalypse, except perhaps via a worldwide, militarily enforced agreement to “shut it all down,” as Eliezer Yudkowsky indeed now explicitly advocates. “Ordinary” regulations could, at best, delay the end by a short amount–given the current pace of AI advances, perhaps not more than a few years. Thus, regardless of how likely one considers this scenario, one might want to focus more on the other scenarios for methodological reasons alone!